手册

Version:

2019.4

- Unity 用户手册 (2019.4 LTS)

- 包

- 已验证包

- 2D Animation

- 2D Common

- 2D Path

- 2D Pixel Perfect

- 2D PSD Importer

- 2D SpriteShape

- Adaptive Performance

- Adaptive Performance Samsung Android

- Addressables

- Advertisement

- Alembic

- Analytics Library

- Android Logcat

- AR Foundation

- AR Subsystems

- ARCore XR Plugin

- ARKit Face Tracking

- ARKit XR Plugin

- Asset Bundle Browser

- Barracuda

- Burst

- Core RP Library

- Custom NUnit

- Editor Coroutines

- Google Resonance Audio

- Google VR Android

- Google VR iOS

- High Definition RP

- High Definition RP Config

- In App Purchasing

- Input System

- Lightweight RP

- Magic Leap XR Plugin

- Mathematics

- Mobile Notifications

- Multiplayer HLAPI

- Oculus Android

- Oculus Desktop

- Oculus XR Plugin

- OpenVR Desktop

- Polybrush

- Post Processing

- ProBuilder

- Profile Analyzer

- Quick Search

- Remote Config

- Scriptable Build Pipeline

- Searcher

- Settings Manager

- Shader Graph

- Subsystem Registration

- Test Framework

- TextMesh Pro

- 时间轴

- Unity Collaborate

- Universal RP

- Visual Effect Graph

- Vuforia Engine AR

- Windows Mixed Reality

- Windows XR Plugin

- XR Interaction Subsystems

- XR Legacy Input Helpers

- XR Plugin Management

- 预览包

- 2D Entities

- 2D IK

- AI Planner

- Animation Rigging

- Asset Graph

- Build Report Inspector

- Cinemachine

- Code Coverage

- Collections

- Device Simulator

- DOTS Editor

- Entities

- FBX Exporter

- Film and TV Toolbox

- Game Foundation

- Havok Physics for Unity

- Hybrid Renderer

- Immediate Window

- Jobs

- Kinematica

- 内存性能分析器 (Memory Profiler)

- MeshSync

- ML Agents

- MockHMD XR Plugin

- Package Development

- Package Validation Suite

- Performance testing API

- Platforms

- Platforms Android

- Platforms Linux

- Platforms macOS

- Platforms Web

- Platforms Windows

- PlayableGraph Visualizer

- ProGrids

- Project Tiny Full

- Streaming Image Sequence

- Terrain Tools

- UI Builder

- Unity AOV Recorder

- Unity Distribution Portal

- Unity NetCode

- Unity Physics

- Unity Recorder

- Unity Reflect

- Unity Render Streaming

- Unity Simulation Client

- Unity Simulation Core

- Unity Transport

- Unity User Reporting

- USD

- Vector Graphics

- WebGL Publisher

- WebRTC

- Xiaomi SDK

- XR Interaction Toolkit

- 内置包

- 2D Sprite

- 2D Tilemap Editor

- AI

- Android JNI

- 动画

- Asset Bundle

- Audio

- 布料

- Director

- Image Conversion

- IMGUI

- JSONSerialize

- Particle System

- 物理 (Physics)

- Physics 2D

- Screen Capture

- Subsystems

- Terrain

- Terrain Physics

- Tilemap

- UI

- UIElements

- Umbra

- Unity Analytics

- Unity UI

- Unity Web Request

- Unity Web Request Asset Bundle

- Unity Web Request Audio

- Unity Web Request Texture

- Unity Web Request WWW

- Vehicles

- Video

- VR

- Wind

- XR

- 按关键字排列的包

- Unity 的 Package Manager

- 创建自定义包

- 已验证包

- Unity 2019 中的新功能

- 在 Unity 中操作

- 安装 Unity

- Unity 的界面

- 资源工作流程

- 创建游戏玩法

- 编辑器功能

- 分析

- 升级指南

- 导入

- 输入

- 2D

- 图形

- 渲染管线

- 摄像机

- 后期处理

- 光照

- 网格、材质、着色器和纹理

- 网格组件

- 创建和使用材质

- 纹理

- 编写着色器

- 标准着色器

- 标准粒子着色器

- 旧版着色器

- 内置着色器的用途和性能

- 普通着色器系列

- 透明着色器系列

- 透明镂空着色器系列

- 自发光着色器系列

- 反光着色器系列

- 反射顶点光照 (Reflective Vertex-Lit)

- 反光漫射 (Reflective Diffuse)

- 反光镜面反射 (Reflective Specular)

- 反光凹凸漫射 (Reflective Bumped Diffuse)

- 反光凹凸镜面反射 (Reflective Bumped Specular)

- 反光视差漫射 (Reflective Parallax Diffuse)

- 反光视差镜面反射 (Reflective Parallax Specular)

- 反光法线贴图无光照 (Reflective Normal Mapped Unlit)

- 反光法线贴图顶点光照 (Reflective Normal mapped Vertex-lit)

- 着色器参考

- 粒子系统

- 选择粒子系统解决方案

- 内置粒子系统

- 使用内置粒子系统

- 粒子系统顶点流和标准着色器支持

- 粒子系统 GPU 实例化

- 粒子系统 C# 作业系统集成

- 组件和模块

- 粒子系统 (Particle System)

- 粒子系统模块

- 粒子系统 (Particle System) 主模块

- Emission 模块

- Shape 模块

- Velocity over Lifetime 模块

- Noise 模块

- Limit Velocity Over Lifetime 模块

- Inherit Velocity 模块

- Force Over Lifetime 模块

- Color Over Lifetime 模块

- Color By Speed 模块

- Size over Lifetime 模块

- Size by Speed 模块

- Rotation Over Lifetime 模块

- Rotation By Speed 模块

- External Forces 模块

- Collision 模块

- Triggers 模块

- Sub Emitters 模块

- Texture Sheet Animation 模块

- Lights 模块

- Trails 模块

- Custom Data 模块

- Renderer 模块

- 粒子系统力场 (Particle System Force Field)

- 内置粒子系统示例

- Visual Effect Graph

- 创建环境

- 天空

- 视觉效果组件

- 高级渲染功能

- 优化图形性能

- 颜色空间

- 图形教程

- 物理系统

- 脚本

- 多玩家和联网

- 音频

- 视频概述

- 动画

- 用户界面 (UI)

- 导航和寻路

- Unity 服务

- 设置项目启用 Unity 服务

- Unity Organizations

- Unity Ads

- Unity Analytics

- Unity Cloud Build

- Automated Build Generation

- 支持的平台

- 支持的 Unity 版本

- 版本控制系统

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Git 配置

- 使用 Unity Editor 对 Unity Cloud Build 进行 Git 配置

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Mercurial 配置

- 使用 Unity Editor 对 Unity Cloud Build 进行 Mercurial 配置

- 将 Apache Subversion (SVN) 用于 Unity Cloud Build

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Perforce 配置

- 使用 Unity Editor 对 Unity Cloud Build 进行 Perforce 配置

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Plastic 配置

- 发布到 iOS

- 高级选项

- 在 Unity Cloud Build 中使用可寻址资源

- 编译清单

- Cloud Build REST API

- Unity Cloud Content Delivery

- Unity IAP

- 设置 Unity IAP

- 跨平台指南

- 应用商店指南

- 实现应用商店

- Unity Collaborate

- Unity Cloud Diagnostics

- Unity Integrations

- Multiplayer 服务

- XR

- 开源代码仓库

- Asset Store 发布

- 平台开发

- 将“Unity 用作库”用于其他应用程序

- 启用深层链接

- 独立平台

- macOS

- Apple TV

- WebGL

- iOS

- Android

- Windows

- 将 Unity 集成到 Windows 和 UWP 应用程序中

- Windows 通用

- 通用 Windows 平台

- 移动平台开发者检查清单

- 实验性

- 旧版主题

- 最佳实践指南

- 专家指南

- 术语表

- Unity 用户手册 (2019.4 LTS)

- XR

- Unity AR 开发入门

Unity AR 开发入门

为了实现 AR 开发入门,Unity 建议使用 AR Foundation 为 Unity 支持的手持式 AR 设备和可穿戴 AR 设备创建应用程序。

AR Foundation 允许您在 Unity 中以多平台方式使用增强现实平台。该软件包可提供一个供 Unity 开发者使用的界面,但并未自行实现任何 AR 功能。

要在目标设备上使用 AR Foundation,您还需要为 Unity 正式支持的每个目标平台下载并安装单独的软件包:

- Android 上的 ARCore XR 插件

- iOS 上的 ARKit XR 插件

- Magic Leap 上的 Magic Leap XR 插件

- HoloLens 上的 Windows XR 插件

有关如何使用 XR 插件管理系统来配置项目的说明,请参阅针对 XR 配置 Unity 项目页面。

AR Foundation 支持以下功能:

| 功能 | 描述 |

|---|---|

| 设备跟踪 | 跟踪设备在物理空间中的位置和方向。 |

| 射线投射 | 通常用于确定虚拟内容的显示位置,即射线(通过原点和方向来定义)与 AR 设备检测和/或跟踪到的真实世界特征相交的位置。Unity 的一些内置功能允许在 AR 应用程序中使用射线投射。 |

| 平面检测 | 检测水平和垂直表面(例如咖啡桌、墙壁)的大小和位置。这些表面被称为“平面”。 |

| 参考点 | 跟踪平面和特征点随时间变化的位置。 |

| 点云检测 | 检测所捕获的摄像机图像中在视觉上明显不同的特征,并使用这些点来了解设备相对于周围世界的位置。 |

| 手势 | 根据人的手,将手势识别为输入事件。 |

| 面部跟踪 | 访问面部标志(这是检测到的面部的网格化表示)以及混合形状信息(可以将这些信息馈入到面部动画绑定中)。面部管理器 (Face Manager) 可以配置用于面部跟踪的设备,并为每个检测到的面部创建游戏对象。 |

| 2D 图像跟踪 | 检测环境中的特定 2D 图像。跟踪图像管理器 (Tracked Image Manager) 自动创建游戏对象来表示所有识别到的图像。可以根据是否存在特定图像来更改 AR 应用程序。 |

| 3D 对象跟踪 | 将真实世界对象的数字表示形式导入到 Unity 应用程序中,并在环境中检测这些对象。跟踪对象管理器 (Tracked Object Manager) 为每个检测到的物理对象创建游戏对象,从而使应用程序可以根据是否存在特定的真实世界对象而改变。 |

| 环境探针 | 检测环境特定区域中的光照和颜色信息,这有助于使 3D 内容与周围环境无缝融合。环境探针管理器 (Environment Probe Manager) 使用此信息在 Unity 中自动创建立方体贴图。 |

| 网格 | 生成与物理空间相对应的三角形网格,因此更能够与物理环境的表示形式进行交互和/或在视觉上覆盖细节。 |

| 2D 和 3D 身体跟踪 | 提供摄像机取景框中识别的人体的 2D(屏幕空间)或 3D(世界空间)表示。在 2D 检测中会使用包含 17 个关节的层级视图以屏幕空间坐标来表示人体。在 3D 检测中会使用包含 93 个关节的层级视图以世界空间变换组件来表示人体。 |

| 人体分段 | 人体子系统 (Human Body Subsystem) 为应用程序提供人体模板和深度分段图像。模板分段图像针对每个像素确定该像素是否包含一个人物。对于与识别到的人物相关的每个像素,深度分段图像包含与设备的估计距离。将这些分段图像一起使用可以使渲染的 3D 内容被真实世界的人体逼真地遮挡。 |

| 遮挡 | 将到物理世界中对象的距离应用于渲染的 3D 内容,从而实现物理对象与虚拟对象的逼真混合。 |

| 参与者跟踪 | 在共享 AR 会话中跟踪其他设备的位置和方向。 |

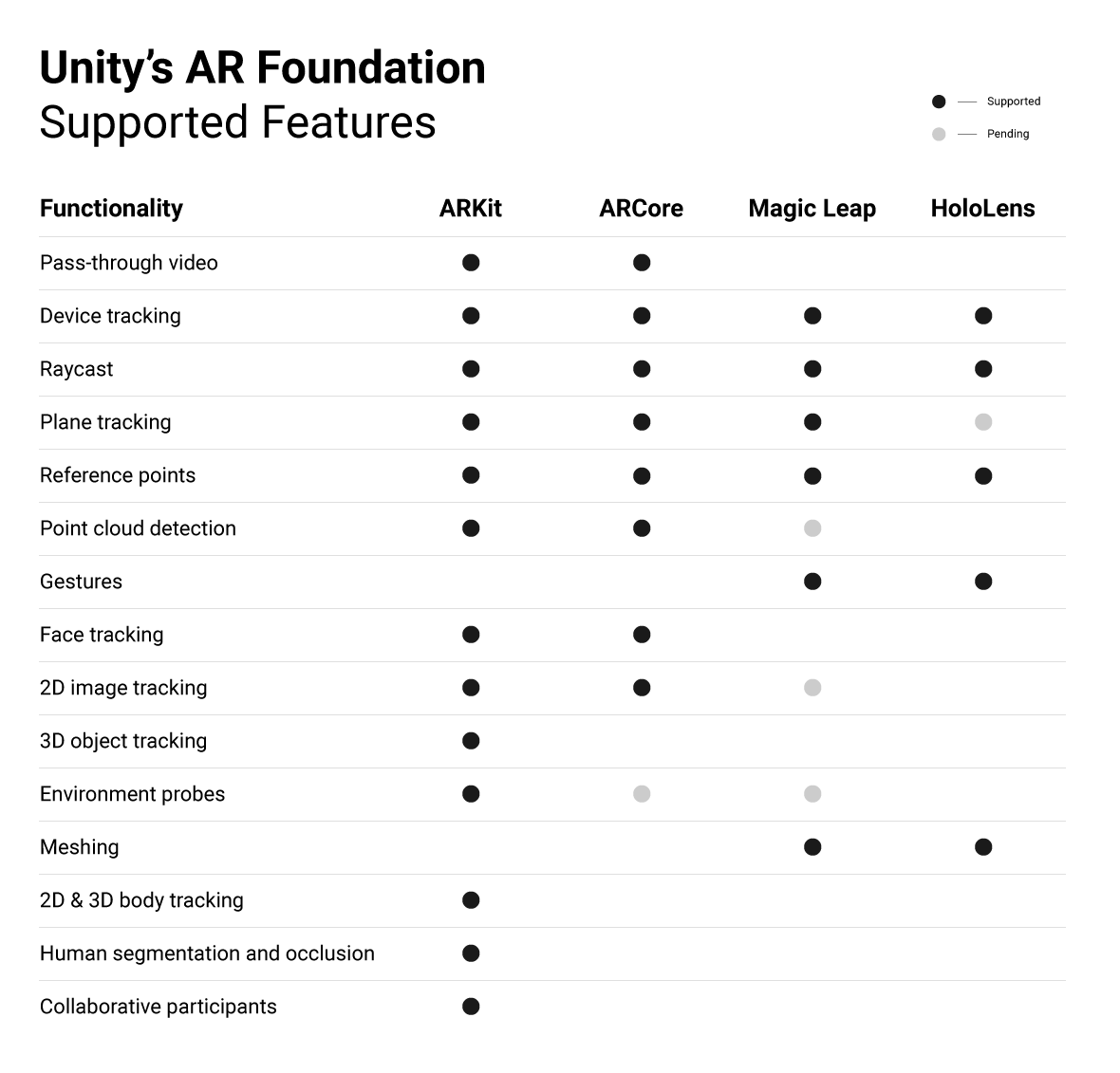

AR 平台支持

AR Foundation 不会自行实现任何 AR 功能,而是会定义一个多平台 API,允许开发者使用多个平台通用的功能。

AR Foundation 可跨不同平台支持以下功能:

有关如何下载和使用 AR Foundation 的更多信息,请参阅 AR Foundation 软件包文档。

版权所有 © 2020 Unity Technologies. Publication 2019.4